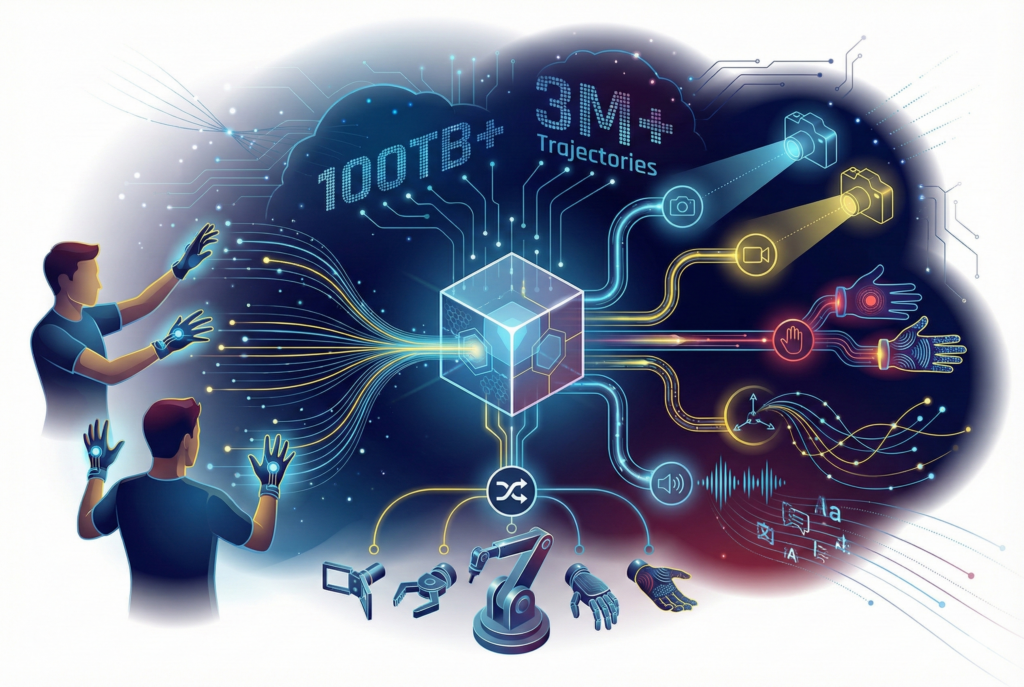

피지컬 AI 데이터셋 (센서 글로브 기반 수집, Manipulation Task)

본 데이터셋은 500명 이상의 전문 인력이 고정밀 센서 글러브를 착용하고 수집한 300만 건 이상의 조작(Manipulation) 궤적과 100TB급 규모를 자랑하는 대규모 멀티모달 데이터셋입니다. RGB-D 멀티뷰 비전, 다차원 촉각, 오디오, 텍스트가 완벽하게 동기화된 이 데이터는 특정 하드웨어에 종속되지 않는 ‘Robot-Agnostic’ 특성을 지녀, 수집된 5지(finger) 모션을 4지 로봇 등 다양한 형태의 엔드 이펙터(End-effector)로 유연하게 리타겟팅할 수 있습니다. 이미 글로벌 대형 물류 기업의 실제 현장에 투입된 상용 휴머노이드 로봇의 학습을 통해 실효성이 검증된 만큼, 복잡한 하드웨어 제약 없이 범용 로봇 조작 지능(General Manipulation Intelligence)을 즉시 고도화할 수 있는 최적의 솔루션입니다.

활용 사례 및 분야

하드웨어 제약으로 인해 양질의 데이터를 직접 구축하기 어려운 스타트업이나 연구실에, 즉시 학습 가능한(Ready-to-train) 환경을 제공합니다.

1. 로봇 모방 학습 및 행동 복제 (Imitation Learning & Behavior Cloning)

- 사람의 자연스러운 손 움직임을 로봇이 그대로 학습하는 행동 복제(Behavior Cloning) 모델 개발에 최적화되어 있습니다.

- 단순한 위치 이동(Pick-and-Place)을 넘어, 비정형 물체를 다루거나 도구를 사용하는 등 고난이도 조작 기술(Dexterous Manipulation)을 훈련시킬 수 있습니다.

2. 이기종 로봇 간 모션 리타겟팅 (Cross-Morphology Retargeting)

- Robot-Agnostic 특성을 활용하여, 사람의 5지(Finger) 데이터를 2지 그리퍼(Gripper)나 3~4지 로봇 핸드로 변환하는 알고리즘 연구 및 검증에 활용 가능합니다.

- 특정 하드웨어 없이도 범용적인 조작 지능(General Manipulation Policy)을 구축하려는 연구에 필수적인 데이터입니다.

3. 멀티모달 기반의 상황 인지 (Multi-modal Perception)

- 시각(Vision) 정보만으로는 파악하기 힘든 물체의 강성, 무게감, 미끄러짐 등을 촉각(Tactile) 및 고유감각(Proprioception) 데이터와 결합하여 학습할 수 있습니다.

- 시각-촉각 융합(Visuo-tactile) 모델을 통해 어두운 환경이나 시야가 가려진 상황(Occlusion)에서의 조작 정확도를 높이는 데 활용됩니다.

4. 지능형 물류 및 제조 자동화 (Logistics & Manufacturing Automation)

- 실제 활용 분야: 택배 분류, 비정형 물품 패키징, 부품 조립(Assembly) 등 정교한 힘 조절이 필요한 공정.

- 깨지기 쉬운 물건(달걀, 유리 등)이나 변형이 심한 물체(의류, 봉투 등)를 파손 없이 다루는 파지(Grasping) 알고리즘 고도화에 적용됩니다.

5. 가사 및 서비스 로봇 (Service & Household Robots)

- 요리, 세탁물 개기, 정리 정돈 등 인간의 일상적인 개입이 필요한 복잡한 가사 노동 시나리오 학습.

- 제공된 텍스트/음성 데이터를 결합하여, 사람의 명령(“빨간색 컵을 조심해서 옮겨줘”)을 이해하고 수행하는 VLA(Vision-Language-Action) 모델 훈련에 활용 가능합니다.

데이터셋 스펙

| 구분 | 상세 내용 |

| 데이터 타입 |

Multi-modal Sensor Data • Vision: RGB, RGB-D (Multi-view Camera Setup) • Tactile: 고정밀 센서 글러브 기반의 다차원 촉각 데이터 • Kinematics: 3D 공간 궤적(Spatial Trajectories), 핸드 모션(Hand Pose) • Language: 텍스트(Text) 명령어, 음성(Audio) 데이터 동기화 • Annotation: 전 데이터 Fully Labeled/Annotated 완료 |

| 수집 방식 |

Human Demonstration via Sensor Gloves (센서 글러브 기반 휴먼 데모) • Method: 로봇 하드웨어 없이 사람이 직접 센서 글러브를 착용하고 작업 수행 • Benefit: 특정 로봇 기구학(Kinematics)에 종속되지 않는 Robot-Agnostic 데이터 확보 • Operator: 500명 이상의 전문 오퍼레이터에 의한 대규모 수집 • Environment: 전문 스튜디오/공장 환경에서 낮 시간대(Daytime) 촬영 |

| 파일 포맷 |

Standard Robotics Format

|

| 판매 가능 수량 |

제한 없음 |